24 Канал имеет эксклюзивное право на перевод и публикацию колонок Project Syndicate. Републикация полной версии текста запрещена. Колонка изначально вышла на сайте Project Syndicate и публикуется с разрешения правообладателя.

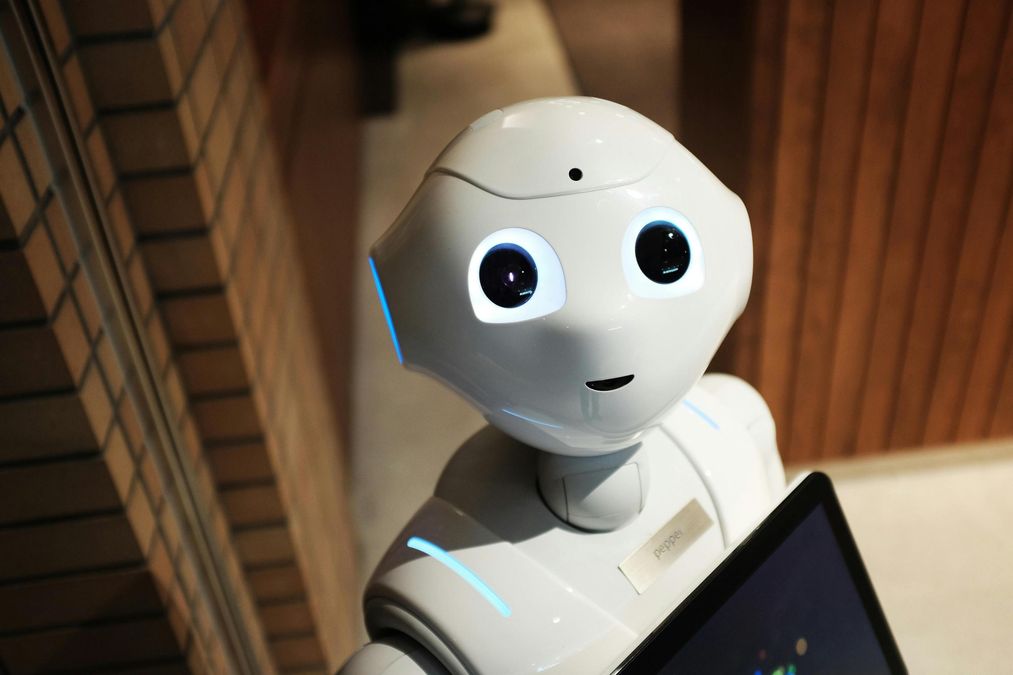

Почему ИИ на самом деле не является умным?

Реальность такова, что системы искусственного интеллекта не являются и никогда не будут друзьями, компаньонами или агентами. Они есть и всегда будут оставаться машинами. Мы должны быть честными в этом и противостоять обманчивому маркетингу, который утверждает обратное.

Самый обманчивый термин из всех – "искусственный интеллект". Эти системы на самом деле не являются разумными, а то, что мы сегодня называем "ИИ", – это просто набор технических инструментов, предназначенных для имитации определенных когнитивных функций. Они не способны к настоящему пониманию и не являются ни объективными, ни справедливыми, ни нейтральными.

Они также не становятся умнее. Системы на основе ИИ в своей работе полагаются на данные, все чаще эти данные генерируют такие инструменты как ChatGPT. В результате возникает петля обратной связи, которая перерабатывает данные, не обеспечивая более глубокого понимания.

Если говорить глубже, то интеллект – это не только решение задач, это также то, как эти задачи рассматриваются и выполняются. Несмотря на технические возможности, модели на основе ИИ остаются ограниченными определенными сферами, такими как обработка больших наборов данных, выполнения логических выводов и вычислений.

Однако, когда речь идет о социальном интеллекте, машины могут только имитировать эмоции, взаимодействия и отношения. Например, медицинского робота можно запрограммировать плакать, когда плачет пациент, однако никто не будет спорить с тем, что он не испытывает настоящую грусть. Того же робота можно так же легко запрограммировать дать пощечину пациенту. Он выполнит эту команду с такой же точностью и с таким же отсутствием аутентичности и самосознания.

Машине безразлично – она просто выполняет инструкции. Независимо от того, насколько развитыми станут такие системы, это не изменится.

Проще говоря, машинам не хватает моральной свободы действий. Их поведение регулируется шаблонами и правилами, созданными людьми, тогда как человеческая мораль основана на автономии – способности распознавать этические нормы и вести себя соответственно. Системы искусственного интеллекта, напротив, разработаны для функциональности и оптимизации. Они могут адаптироваться путем самообучения, но правила, которые они генерируют, не имеют внутреннего этического значения.

Как уместнее называть искусственный интеллект?

Рассмотрим беспилотные автомобили. Чтобы как можно быстрее добраться из пункта А в пункт Б, беспилотное транспортное средство может разработать правила для оптимизации времени путешествия. Если наезд на пешеходов поможет достичь этой цели, автомобиль может это сделать, если ему не прикажут этого не делать. Он не может понять моральных последствий причинения вреда людям.

Частично это объясняется тем, что машины не способны постичь принцип обобщаемости – идею о том, что действие является этичным лишь тогда, когда его можно оправдать как универсальное правило. Моральное суждение зависит от способности привести правдоподобное обоснование, которое другие могут разумно принять. Это то, что мы часто называем "вескими причинами". В отличие от машин, люди способны использовать обобщающие моральные рассуждения и поэтому могут судить, являются ли их действия правильными или неправильными.

Таким образом, термин "системы на основе данных" (data-based systems) является более уместным, чем "искусственный интеллект". Он отражает то, что ИИ на самом деле может делать: генерировать, собирать, обрабатывать и оценивать данные для наблюдений и прогнозов. Он также объясняет сильные и ограниченные стороны современных технологий.

По сути, это системы, которые используют высокосложные математические процессы для анализа огромных объемов данных – ничего больше. Люди могут взаимодействовать с ними, но коммуникация является полностью односторонней. Системы на основе данных не осознают, что они "делают" или что происходит вокруг них.

Как использовать ИИ с умом?

Это не значит, что данные не могут принести пользу человечеству или планете. Наоборот, мы можем и должны полагаться на них в сферах, где их возможности превышают наши собственные. Но мы также должны активно управлять и смягчать этические риски, которые они представляют. Разработка систем данных, основанных на правах человека, и создание Международного агентства по вопросам систем данных в ООН были бы важными первыми шагами в этом направлении.

За последние два десятилетия крупные технологические компании изолировали нас и раскололи наши общества через социальные сети – правильнее их назвать "антисоциальными сетями", учитывая, что они вызывают зависимость и имеют разрушительный характер. Теперь эти же компании продвигают радикально новое видение: замену человеческих связей "друзьями" на основе искусственного интеллекта.

В то же время эти компании продолжают игнорировать так называемую "проблему черного ящика": неотслеживаемость, непредсказуемость и отсутствие прозрачности в алгоритмических процессах, лежащих в основе автоматизированных оценок, прогнозов и решений. Эта непрозрачность в сочетании с высокой вероятностью предвзятых и дискриминационных алгоритмов неизбежно приводит к предвзятым и дискриминационным результатам.

Риски, возникающие из-за data-based systems, не являются теоретическими. Эти системы уже имеют негативное влияние на нашу личную и профессиональную жизнь, манипулируя нами экономически и политически. Однако руководители технологических компаний призывают нас позволить инструментам data-based systems управлять нашими решениями.

Чтобы защитить нашу свободу и достоинство, а также свободу и достоинство будущих поколений, мы должны не позволять машинам маскироваться под то, чем они не являются – под нас.